Produkter

Vad vi erbjuder

Generativ AI Container

Våra AI-containrar är kraftfulla och effektiva lösningar som gör det möjligt för kunder att skapa och distribuera generativa AI-tjänster i sitt datacenter. Servrarna är för-konfigurerade och redo att användas, vilket ger en smidig upplevelse för användarna. Med våra AI-servrar kan du enkelt utnyttja kraften i generativ AI och använda dess kapacitet för att driva innovation och automatisera affärsprocesser. Servrarna erbjuder avancerade skalbarhetsalternativ, vilket gör det möjligt för dig att uppgradera till standard- och företagsnivåer efter dina behov. Upplev fördelarna med vår AI-server och lås upp AI:s fulla potential i din organisation.

Generativ AI Studio

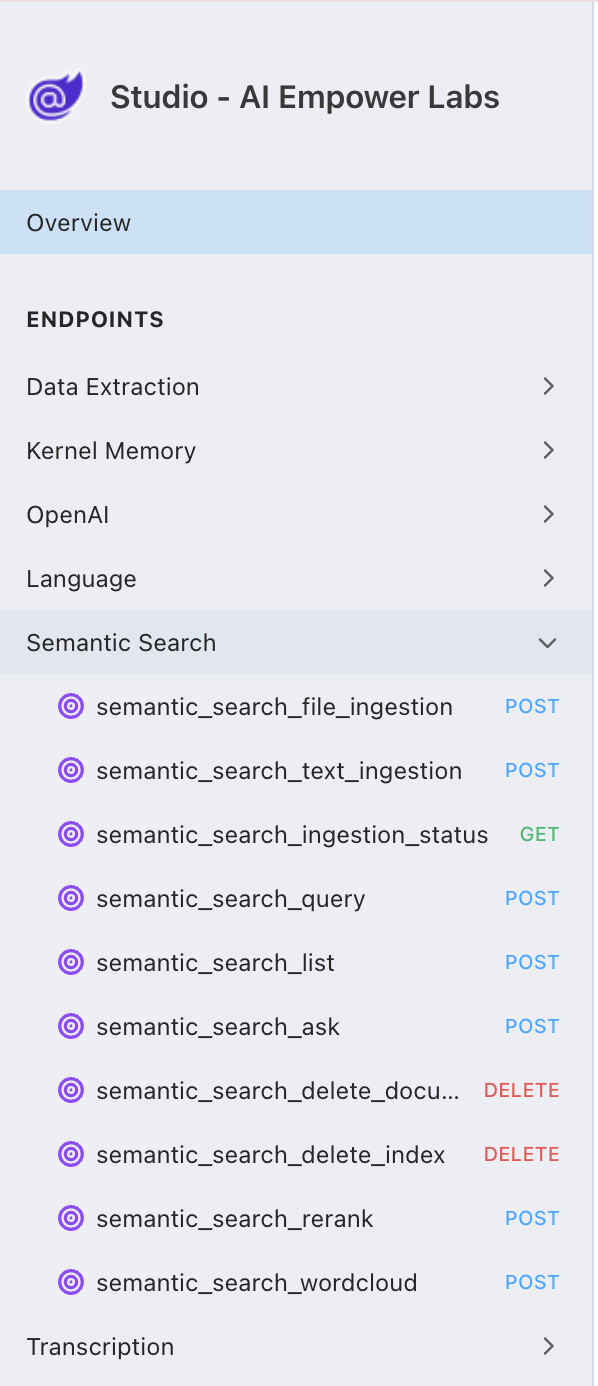

AI Empower Labs Studio är ett användargränssnitt som gör det möjligt för dig att köra och använda servercontainers direkt utan att behöva koda alls. Studion är inbyggd i containrarna och inkluderar stora språkmodeller, semantisk sökning och maskininlärningsfunktioner för generativa AI-tjänster, med RAG och tal-till-text-tjänster tillgängliga.

Studion låter dig testa och köra semantisk sökning – indexera din egen data och använd generativ AI-teknologi för att söka i din egen data eller använda dessa data med de inbyggda stora språkmodellerna.

Skapa och kör kompletta virtuella assistenter för chat och röst utan att behöva koda.

Varför välja våra AI produkter?

Vi erbjuder containrar för, stora språkmodeller, Retrieval-Augmented-Generation (RAG), tal-till-text-transkribering, flerspråkig översättning och semantisk sökfunktionalitet.

Idag strävar företag efter att utnyttja kapabiliteterna hos stora språkmodeller (LLM) som GPT, använda RAG för förbättrad datasökning och -hämtning, samt få tillgång till toppmodern transkribering och flerspråkiga tjänster. Men att integrera dessa sofistikerade AI-lösningar direkt på företagets hårdvaruinfrastruktur är en formidabel uppgift.

AI Empower Labs erbjuder en skräddarsydd lösning på dessa utmaningar, med ett strömlinjeformat och effektivt tillvägagångssätt som utmärker sig inom AI-tjänsternas landskap. Redo för enterprise företag.

Hjälp att navigera komplexiteten i avancerad AI-integration

- Hårdvaru- och GPU-optimering:

Att hantera betydande GPU-krav för dessa modeller kräver strategisk resursallokering och skalbarhet. - Utvecklande mjukvaruekosystem: Mjukvaruutvecklingslandskapet, särskilt utanför Python, har ännu inte mognat helt, vilket försvårar en sömlös integration av generativa AI-teknologier.

- Databearbetning och vektorisering:

Att använda LLM:er och RAG effektivt innebär komplexa processer som embedding, tokenisering och vektorisering, vilket kräver djupgående expertis. - Vektorlager och avancerad sökning:

Att etablera effektiv vektorlagerhantering och sofistikerade sökfunktioner för snabb informationshämtning utgör en betydande teknisk utmaning. - Databasintegration:

Att uppnå en sömlös databasintegration samtidigt som man upprätthåller datasäkerhet och integritet innebär hinder. - Förbättrade RAG-funktioner:

Att skapa avancerade RAG-söknings- och filtreringsfunktioner kräver specialiserad kunskap och resurser.

AI Empower Labs: Hjälp att navigera komplexiteten i avancerad AI-integration

- Eliminering av behovet av dedikerade utvecklingsteam:

Med AI Empower Labs kan företag undvika behovet av omfattande utvecklingsresurser genom att erbjuda en nyckelfärdig lösning som är redo för omedelbar implementering. - Levererar exceptionellt värde:

Genom att tillhandahålla en integrerad lösning som enkelt anpassas till befintlig hårdvara och system, säkerställer AI Empower Labs att företag kan utnyttja AI-teknologiernas fulla potential utan ansträngning. - Underlättar bulkdatabearbetning:

Plattformens kapacitet för bulkdataintag utmärker sig, vilket möjliggör snabb integration och implementering, minimerar driftstopp och påskyndar operativ beredskap.

AI Empower Labs i praktiken

I grund och botten är AI Empower Labs mer än bara en AI-tjänsteleverantör. Det är en holistisk lösning som är utformad för organisationer som står inför uppgiften att integrera komplexa AI-system i sin hårdvara. Genom att avlägsna tekniska hinder och strömlinjeforma implementeringen gör AI Empower Labs det möjligt för företag att utnyttja de omfattande kapabiliteterna hos banbrytande AI-teknologier och säkerställa att de förblir konkurrenskraftiga på en ständigt föränderlig marknad.

Världen av stora språkmodeller (LLM:er), inklusive GPT och BERT, tillsammans med teknologier som Retrieval-Augmented Generation (RAG) och processer som transkribering och översättning, utgör betydande utmaningar för företag som vill utnyttja dessa verktyg på sin infrastruktur. Komplexiteten som är inblandad i att säkerställa inbyggt stöd för viktiga processer som embedding, tokenisering, vektorer, vektorlager och sökning, tillsammans med behovet av GPU-acceleration och sofistikerad databashantering för datalagring, samt implementeringen av avancerade RAG-söknings- och filtreringstekniker, representerar en avsevärd utmaning för många företag.

Komplexitetens olika delar

- Hårdvara och infrastruktur: Behovet av högpresterande GPU:er och specialiserad hårdvara för att hantera de intensiva beräkningskraven för att köra LLM- och RAG-system kräver en välorganiserad infrastruktur för att optimera prestanda och kompatibilitet.

- Mjukvara och utvecklingsekosystem: Det nuvarande tillståndet för mjukvaruutveckling, särskilt utanför Python, saknar full mognad för en smidig integration av dessa avancerade teknologier. Utvecklare måste ofta navigera genom ett fragmenterat landskap av verktyg och språk, ytterligare komplicerat av behovet av avancerade RAG-funktioner.

- Integrations- och driftutmaningar: De operativa komplexiteterna i att integrera dessa teknologier i ett sammanhängande system kräver en ingående förståelse för komponenternas inre funktioner och beroenden, vilket kräver finjustering för att effektivt hantera beräkningsbelastningar.

En All-in-One Plattform

Features:

- Bulkdatainmatning: Denna funktion utmärker sig genom att möjliggöra för företag att snabbt ladda upp och bearbeta stora mängder text, vilket underlättar full utnyttjande av dataresurser.

- Omfattande databehandlingsstöd: Genom att erbjuda inbyggt stöd för en mängd olika embedding- och tokeniseringstekniker säkerställer plattformen snabb och korrekt informationshämtning genom avancerad vektorlagring och sökfunktioner.

- Optimerad prestanda och flerspråkigt stöd: Utformad med högpresterande databehandling i åtanke, maximerar plattformen GPU-användningen och erbjuder flerspråkigt stöd, vilket möjliggör sömlös integration av dessa komplexa modeller och processer på ett företags infrastruktur.

Ai Empower Labs allt-i-ett-plattform representerar ett betydande framsteg i att göra möjligheterna med LLM:er, RAG, transkribering och översättning mer tillgängliga för företag, vilket eliminerar behovet av djup teknisk expertis inom AI och maskininlärning. Genom att förenkla implementeringen och driften av dessa teknologier kan företag nu utnyttja deras kraft för att driva innovation och värde, med fokus på sina kärnstrategier snarare än på komplexiteten i deras implementering.

Helt gratis - utan tidsbegräning!

En container kan köras helt gratis med alla funktioner inkluderade, men med maximalt 30 förfrågningar per minut.

När ditt företag växer och kräver mer resurser, gör våra skalbarhetsuppgraderingar det enkelt att skala upp din AI-infrastruktur till standard- och företagsnivåer. Uppgraderingsmöjligheterna ger förbättrad prestanda, tillförlitlighet och flexibilitet, vilket säkerställer att dina AI-tjänster kan hantera högre arbetsbelastningar och ändå leverera optimala resultat.

Med AI Empower Labs skalbarhetsuppgradering kan organisationer smidigt övergå till högre nivåer av skalbarhet utan några avbrott eller driftstopp.

Upplev kraften i skalbarhet och lås upp nya möjligheter med vår skalbarhetsuppgradering.

APIs för utvecklings teams

Bygg in generativ AI i dina affärsapplikationer med AI EmpowerLabs API:er. Kompatibla med OpenAI och Microsoft Azure API:er.

- Konfigurera och lägg till data i dina modeller med AI Empower Labs Studio-gränssnittet.

- Integrera dessa i dina applikationer med hjälp av API:erna.